Gaussův proces - Gaussian process

v teorie pravděpodobnosti a statistika, a Gaussův proces je stochastický proces (kolekce náhodných proměnných indexovaných časem nebo prostorem), takže každá konečná kolekce těchto náhodných proměnných má a vícerozměrné normální rozdělení, tj. každý konečný lineární kombinace z nich je normálně distribuováno. Distribuce Gaussova procesu je společná distribuce ze všech těchto (nekonečně mnoho) náhodných proměnných, a jako takové se jedná o distribuci přes funkce s kontinuální doménou, např. čas nebo prostor.

Algoritmus strojového učení, který zahrnuje Gaussův proces, používá líné učení a míra podobnosti mezi body ( funkce jádra) předpovědět hodnotu neviditelného bodu z tréninkových dat. Predikce není jen odhadem pro daný bod, ale má také informace o nejistotě - je to jednorozměrné Gaussovo rozdělení.[1]Pro vícevýstupové předpovědi mnohorozměrné Gaussovy procesy[2][3] se používají, pro které vícerozměrná Gaussova distribuce je mezní rozdělení v každém bodě.

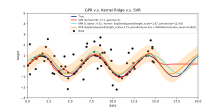

U některých funkcí jádra lze pomocí maticové algebry vypočítat předpovědi pomocí techniky kriging. Když se používá parametrizované jádro, optimalizační software se obvykle používá k přizpůsobení Gaussovskému modelu procesu.

Pojem gaussovské procesy je pojmenován po Carl Friedrich Gauss protože je založen na představě Gaussova rozdělení (normální distribuce ). Na Gaussovy procesy lze pohlížet jako na nekonečně rozměrné zobecnění vícerozměrných normálních rozdělení.

Gaussovy procesy jsou užitečné v statistické modelování, těžící z vlastností zděděných z normálního rozdělení. Například pokud a náhodný proces je modelován jako Gaussův proces, lze explicitně získat rozdělení různých odvozených veličin. Mezi takové veličiny patří průměrná hodnota procesu v rozsahu časů a chyba v odhadu průměru pomocí hodnot vzorku v malém množství časů. Zatímco přesné modely se při zvyšování množství dat často špatně škálovají, více aproximační metody byly vyvinuty, které si často zachovávají dobrou přesnost a drasticky snižují výpočetní čas.

Definice

Čas nepřetržitý stochastický proces je Gaussian kdyby a jen kdyby pro každého konečná množina z indexy v sadě indexů

je vícerozměrný Gaussian náhodná proměnná.[4] To je stejné jako říkat každou lineární kombinaci má jednorozměrné normální (nebo Gaussovo) rozdělení.

Použitím charakteristické funkce z náhodných proměnných lze Gaussovu vlastnost formulovat následovně: je Gaussian právě tehdy, když pro každou konečnou sadu indexů , existují skutečné hodnoty , s tak, aby následující rovnost platila pro všechny

- .

kde označuje imaginární jednotka takhle .

Čísla a lze zobrazit jako kovariance a prostředek proměnných v procesu.[5]

Rozptyl

Rozptyl Gaussova procesu je kdykoli konečný formálně[6]:p. 515

- .

Stacionarita

Pro obecné stochastické procesy striktnost stacionárnosti naznačuje širokoúhlý stacionář ale ne každý stacionární stochastický proces se širokým smyslem je stacionární s přísným smyslem. Pro gaussovský stochastický proces jsou však oba pojmy rovnocenné.[6]:p. 518

Gaussovský stochastický proces je stacionárním stacionárním stacionárním způsobem pouze tehdy, je-li stacionárním širokoúhlým stykem.

Příklad

Pro stacionární gaussovské procesy existuje výslovné vyjádření.[7] Jednoduchým příkladem této reprezentace je

kde a jsou nezávislé náhodné proměnné s standardní normální rozdělení.

Kovarianční funkce

Klíčovým faktem gaussovských procesů je, že je lze zcela definovat statistikami druhého řádu.[8] Pokud se tedy předpokládá, že Gaussianův proces má střední nulu, definuje se kovarianční funkce zcela definuje chování procesu. Důležité je, že nezáporná definitivita této funkce umožňuje její spektrální rozklad pomocí Karhunen – Loève expanze. Základní aspekty, které lze definovat pomocí kovarianční funkce, jsou proces ' stacionárnost, izotropie, hladkost a periodicita.[9][10]

Stacionarita odkazuje na chování procesu týkající se oddělení jakýchkoli dvou bodů a . Je-li proces stacionární, záleží na jejich oddělení, , pokud není stacionární, záleží na skutečné poloze bodů a . Například speciální případ souboru Proces Ornstein – Uhlenbeck, a Brownův pohyb proces, je stacionární.

Pokud proces závisí pouze na , euklidovská vzdálenost (ne směr) mezi a , pak je proces považován za izotropní. Proces, který je současně stacionární a izotropní, je považován za homogenní;[11] v praxi tyto vlastnosti odrážejí rozdíly (nebo spíše jejich nedostatek) v chování procesu vzhledem k umístění pozorovatele.

Gaussovské procesy se v konečném důsledku překládají jako převzetí priorit funkcí a plynulost těchto priorit lze vyvolat kovarianční funkcí.[9] Pokud to očekáváme pro „blízké“ vstupní body a jejich odpovídající výstupní body a abychom byli také „na blízku“, pak existuje předpoklad kontinuity. Pokud si přejeme umožnit výrazné posunutí, mohli bychom zvolit drsnější kovarianční funkci. Extrémním příkladem chování je kovarianční funkce Ornstein – Uhlenbeck a druhá mocnina, kde první není nikdy diferencovatelný a druhý nekonečně diferencovatelný.

Periodicita se týká vyvolání periodických vzorců v chování procesu. Formálně je toho dosaženo mapováním vstupu do dvourozměrného vektoru .

Obvyklé kovarianční funkce

Existuje řada běžných kovariančních funkcí:[10]

- Konstantní:

- Lineární:

- bílý gaussovský šum:

- Na druhou exponenciální:

- Ornstein – Uhlenbeck:

- Matérn:

- Periodické:

- Racionální kvadratický:

Tady . Parametr je charakteristická délková stupnice procesu (prakticky „jak blízko“ dva body a se musí navzájem významně ovlivňovat), je Kroneckerova delta a the standardní odchylka kolísání hluku. Navíc, je upravená Besselova funkce řádu a je funkce gama hodnoceno na . Důležité je, že komplikovanou kovarianční funkci lze definovat jako lineární kombinaci jiných jednodušších kovariančních funkcí, aby bylo možné začlenit různé poznatky o dané datové sadě.

Je zřejmé, že inferenční výsledky jsou závislé na hodnotách hyperparametrů (např. a ) definující chování modelu. Populární volba pro je poskytnout maximálně a posteriori (MAP) to odhaduje s některými vybranými předchozími. Pokud je předchozí velmi téměř uniformní, je to stejné jako maximalizovat mezní pravděpodobnost procesu; marginalizace se provádí nad sledovanými procesními hodnotami .[10] Tento přístup je také známý jako maximální pravděpodobnost II, maximalizace důkazůnebo empirický Bayes.[12]

Kontinuita

Pro Gaussian proces, kontinuita v pravděpodobnosti je ekvivalentní k spojitost střední kvadrát,[13]:145a kontinuita s pravděpodobností jedna je ekvivalentní k kontinuita vzorku.[14]:91 „Gaussovy procesy jsou diskontinuální v pevných bodech.“Druhá možnost implikuje, ale neznamená to, kontinuitu v pravděpodobnosti. Spojitost v pravděpodobnosti platí právě tehdy, když průměr a autovariance jsou spojité funkce. Kontinuita vzorku byla naopak náročná i pro stacionární Gaussovy procesy (jak pravděpodobně poznamenal nejprve Andrey Kolmogorov ) a náročnější pro obecnější procesy.[15]:Sekta. 2.8[16]:69,81[17]:80[18]Jako obvykle se procesem vzorkování rozumí proces, který připouští vzorek kontinuálně modifikace.[19]:292[20]:424

Stacionární pouzdro

Pro stacionární Gaussův proces některé podmínky v jeho spektru jsou dostatečné pro kontinuitu vzorku, ale nemusí být nezbytné. Nezbytná a dostatečná podmínka, někdy nazývaná Dudley-Ferniqueova věta, zahrnuje funkci definován

(pravá strana nezávisí na kvůli stacionárnosti). Kontinuita v pravděpodobnosti je ekvivalentní kontinuitě na Když konvergence na (tak jako ) je příliš pomalý, kontinuita vzorku z může selhat. Konvergence následujících integrálů je důležitá:

tyto dva integrály jsou si rovny podle integrace substitucí První integrand nemusí být ohraničen jako tedy integrál může konvergovat () nebo se rozcházejí (). Vezmeme-li například pro velké to je pro malé jeden získá když a když V těchto dvou případech funkce roste dál ale obecně tomu tak není. Navíc podmínka

- tady existuje takhle je monotónní

nevyplývá z kontinuity a evidentní vztahy (pro všechny ) a

Věta 1. Nechat být nepřetržitý a spokojený Pak podmínka je nezbytný a dostatečný pro kontinuitu vzorku

Nějaká historie.[20]:424Dostatečnost byla oznámena Xavier Fernique v roce 1964, ale první důkaz publikoval Richard M. Dudley v roce 1967.[19]:Věta 7.1Nutnost prokázal Michael B. Marcus a Lawrence Shepp v roce 1970.[21]:380

Existují ukázkové kontinuální procesy takhle porušují podmínku Příklad nalezený Marcusem a Sheppem [21]:387 je náhodný lakunární Fourierova řada

kde jsou nezávislé náhodné proměnné s standardní normální rozdělení; frekvence jsou rychle rostoucí sekvence; a koeficienty uspokojit Druhý vztah naznačuje odkud téměř jistě, což téměř jistě zajišťuje jednotnou konvergenci Fourierovy řady, a kontinuitu vzorku

Jeho autovariační funkce

není nikde monotónní (viz obrázek), stejně jako odpovídající funkce

Brownův pohyb jako integrál Gaussových procesů

A Wienerův proces (aka Brownův pohyb) je integrálem a bílý šum zobecněný Gaussův proces. Není stacionární, ale má stacionární přírůstky.

The Proces Ornstein – Uhlenbeck je stacionární Gaussův proces.

The Brownův most je (jako proces Ornstein – Uhlenbeck) příkladem Gaussova procesu, jehož přírůstky nejsou nezávislý.

The frakční Brownův pohyb je Gaussův proces, jehož kovarianční funkce je zobecněním Wienerova procesu.

Driscollův zákon nuly jedna

Driscollův zákon nula jedna je výsledkem charakterizujícím vzorové funkce generované Gaussovým procesem.

Nechat být Gaussův proces se střední nulou s nezápornou určitou kovarianční funkcí . Nechat být Reprodukce jádra Hilbertova prostoru s pozitivním určitým jádrem .

Pak

- ,

kde a jsou kovarianční matice všech možných párů body, naznačuje

- .

Co víc,

naznačuje

- .[22]

To má významné důsledky, když , tak jako

- .

Jako takové téměř všechny vzorové cesty Gaussova procesu se střední nulou s pozitivním určitým jádrem bude ležet mimo Hilbertův prostor .

Lineárně omezené Gaussovy procesy

Pro mnoho zajímavých aplikací jsou již dány určité již existující znalosti o daném systému. Zvažte např. případ, kdy výstup Gaussova procesu odpovídá magnetickému poli; zde je skutečné magnetické pole vázáno Maxwellovými rovnicemi a byl by žádoucí způsob začlenění tohoto omezení do Gaussova procesu, protože by to pravděpodobně zlepšilo přesnost algoritmu.

Metoda, jak začlenit lineární omezení do gaussovských procesů, již existuje:[23]

Zvažte výstupní funkci (oceněnou vektorem) o kterém je známo, že se řídí lineárním omezením (tj. je lineární operátor)

Pak omezení lze splnit výběrem , kde je modelován jako gaussovský proces a nález Svatý.

Dáno a s využitím skutečnosti, že Gaussovy procesy jsou uzavřeny lineárními transformacemi, je Gaussův proces pro dodržování omezení se stává

Proto lze lineární omezení zakódovat do střední a kovarianční funkce Gaussova procesu.

Aplikace

Gaussovský proces lze použít jako a předchozí rozdělení pravděpodobnosti přes funkce v Bayesovský závěr.[10][25] Vzhledem k jakékoli sadě N body v požadované doméně vašich funkcí, vezměte a vícerozměrný Gaussian jehož kovariance matice parametr je Gramová matice vašeho N body s některými požadovanými jádro, a vzorek od toho Gaussiana. Pro řešení problému s více výstupy byla vyvinuta Gaussova regrese procesu pro funkci s vektorovou hodnotou. V této metodě je konstruována „velká“ kovariance, která popisuje korelace mezi všemi vstupními a výstupními proměnnými v N body v požadované doméně.[26] Tento přístup byl podrobně rozpracován pro maticově hodnotné gaussovské procesy a zobecněn na procesy s „těžšími ocasy“ jako Studentské procesy.[3]

Odvození spojitých hodnot pomocí Gaussova procesu před je známé jako Gaussova regrese procesu, nebo kriging; rozšíření regrese Gaussova procesu na více cílových proměnných je známý jako spoluzakladatel.[27] Gaussovské procesy jsou tedy užitečné jako mocný nelineární vícerozměrný interpolace nářadí. Gaussovu regresi procesu lze dále rozšířit tak, aby řešila úkoly učení v obou pod dohledem (např. pravděpodobnostní klasifikace[10]) a bez dozoru (např. rozmanité učení[8]) učební rámce.

Gaussovy procesy lze například použít také v souvislosti se směsí expertních modelů.[28][29] Základní důvody takového rámce učení spočívají v předpokladu, že dané mapování nelze dobře zachytit jediným modelem Gaussova procesu. Místo toho je pozorovací prostor rozdělen na podmnožiny, z nichž každá je charakterizována jinou mapovací funkcí; každý z nich se učí prostřednictvím jiné složky Gaussova procesu v postulované směsi.

Gaussova predikce procesu, neboli Kriging

Pokud jde o obecný problém regrese Gaussova procesu (Kriging), předpokládá se, že pro Gaussian proces pozorováno na souřadnicích , vektor hodnot je jen jeden vzorek z vícerozměrného Gaussova rozdělení dimenze rovnající se počtu pozorovaných souřadnic . Proto za předpokladu nulové střední distribuce , kde je kovarianční matice mezi všemi možnými páry pro danou sadu hyperparametrů θ.[10]Jako taková je mezní pravděpodobnost logu:

a maximalizovat tuto mezní pravděpodobnost θ poskytuje úplnou specifikaci Gaussova procesu F. Na tomto místě lze stručně poznamenat, že první člen odpovídá trestnému termínu za neschopnost modelu přizpůsobit pozorované hodnoty a druhý člen trestnímu členu, který se zvyšuje úměrně ke složitosti modelu. Po upřesnění θ dělat předpovědi o nepozorovaných hodnotách na souřadnicích X* je pak pouze otázkou čerpání vzorků z prediktivního rozdělení kde zadní střední odhad A je definován jako

a odhad zadní rozptylu B je definován jako:

kde je kovariance mezi novou souřadnicí odhadu X* a všechny ostatní pozorované souřadnice X pro daný hyperparametrový vektor θ, a jsou definovány jako dříve a je rozptyl v bodě X* podle pokynů θ. Je důležité si uvědomit, že prakticky zadní průměrný odhad („bodový odhad“) je pouze lineární kombinací pozorování ; podobným způsobem rozptyl je ve skutečnosti nezávislá na pozorováních . Známým úzkým místem v predikci Gaussova procesu je, že výpočetní složitost hodnocení závěrů a pravděpodobností je kubická v počtu bodů |X|, a jako takový se může stát neproveditelným pro větší datové sady.[9] Práce na řídkých Gaussových procesech, které jsou obvykle založeny na myšlence vybudování a reprezentativní sada pro daný proces F, pokuste se tento problém obejít.[30][31]

Bayesovské neuronové sítě jako Gaussovy procesy

Bayesovské neuronové sítě jsou zvláštním typem Bayesovská síť který je výsledkem léčby hluboké učení a umělá neuronová síť pravděpodobnostní modely a přiřazení a předchozí distribuce jejich parametry. Výpočet v umělých neuronových sítích je obvykle organizován do sekvenčních vrstev umělé neurony. Počet neuronů ve vrstvě se nazývá šířka vrstvy. Jak šířka vrstvy roste, mnoho Bayesovských neuronových sítí se redukuje na Gaussův proces s a uzavřená forma kompoziční jádro. Tento gaussovský proces se nazývá Gaussianův proces neurální sítě (NNGP). Umožňuje efektivnější vyhodnocení předpovědí z Bayesovských neuronových sítí a poskytuje analytický nástroj k pochopení hluboké učení modely.

Výpočtové problémy

V praktických aplikacích jsou gaussovské procesní modely často hodnoceny na mřížce vedoucí k vícerozměrnému normálnímu rozdělení. Použití těchto modelů pro predikci nebo odhad parametrů pomocí maximální věrohodnosti vyžaduje vyhodnocení vícerozměrné Gaussovské hustoty, což zahrnuje výpočet determinantu a inverze kovarianční matice. Obě tyto operace mají kubickou výpočetní složitost, což znamená, že i pro mřížky skromných velikostí mohou mít obě operace neúměrné výpočetní náklady. Tato nevýhoda vedla k vývoji více aproximační metody.

Viz také

- Bayesova lineární statistika

- Bayesovská interpretace regularizace

- Kriging

- Gaussovo volné pole

- Gauss – Markovův proces

- Gradientně vylepšený kriging (GEK)

- Studentův t-proces

Reference

- ^ „Platypus Innovation: A Simple Intro to Gaussian Processes (a great data modeling tool)“. 2016-05-10.

- ^ Chen, Zexun; Fan, červen; Wang, Kuo (2020). "Poznámky k vícerozměrnému Gaussovu procesu". arXiv:2010.09830 [matematika ].

- ^ A b Chen, Zexun; Wang, Bo; Gorban, Alexander N. (2019). "Vícesměrná Gaussova a Studentova t regrese procesu pro predikci více výstupů". Neural Computing a aplikace. 32 (8): 3005–3028. arXiv:1703.04455. doi:10.1007 / s00521-019-04687-8.

- ^ MacKay, David, J.C. (2003). Informační teorie, odvození a výukové algoritmy (PDF). Cambridge University Press. p. 540. ISBN 9780521642989.

Rozdělení pravděpodobnosti funkce je Gaussovské procesy, pokud pro jakýkoli konečný výběr bodů hustota je Gaussian

- ^ Dudley, R.M. (1989). Skutečná analýza a pravděpodobnost. Wadsworth a Brooks / Cole.

- ^ A b Amos Lapidoth (8. února 2017). Nadace v digitální komunikaci. Cambridge University Press. ISBN 978-1-107-17732-1.

- ^ Kac, M .; Siegert, A.J.F (1947). „Výslovné znázornění stacionárního Gaussova procesu“. Annals of Mathematical Statistics. 18 (3): 438–442. doi:10.1214 / aoms / 1177730391.

- ^ A b Bishop, C.M. (2006). Rozpoznávání vzorů a strojové učení. Springer. ISBN 978-0-387-31073-2.

- ^ A b C Barber, David (2012). Bayesovské uvažování a strojové učení. Cambridge University Press. ISBN 978-0-521-51814-7.

- ^ A b C d E F Rasmussen, C.E .; Williams, C.K.I (2006). Gaussovské procesy pro strojové učení. MIT Stiskněte. ISBN 978-0-262-18253-9.

- ^ Grimmett, Geoffrey; David Stirzaker (2001). Pravděpodobnost a náhodné procesy. Oxford University Press. ISBN 978-0198572220.

- ^ Seeger, Matthias (2004). "Gaussovské procesy pro strojové učení". International Journal of Neural Systems. 14 (2): 69–104. CiteSeerX 10.1.1.71.1079. doi:10,1142 / s0129065704001899. PMID 15112367.

- ^ Dudley, R. M. (1975). „Gaussovský proces a jak k němu přistupovat“ (PDF). Sborník příspěvků z mezinárodního kongresu matematiků. 2. 143–146.

- ^ Dudley, R. M. (1973). "Ukázkové funkce Gaussova procesu". Annals of Probability. 1 (1): 66–103. doi:10.1007/978-1-4419-5821-1_13. ISBN 978-1-4419-5820-4.

- ^ Talagrand, Michel (2014). Horní a dolní hranice pro stochastické procesy: moderní metody a klasické problémy. Ergebnisse der Mathematik und ihrer Grenzgebiete. 3. Folge / Série moderních průzkumů v matematice. Springer, Heidelberg. ISBN 978-3-642-54074-5.

- ^ Ledoux, Michel (1994). "Izoperimetrie a Gaussova analýza". Přednášky z matematiky. 1648. Springer, Berlín. str. 165–294. doi:10.1007 / BFb0095676. ISBN 978-3-540-62055-6.

- ^ Adler, Robert J. (1990). "Úvod do kontinuity, extrémů a souvisejících témat pro obecné gaussovské procesy". Série přednášek - monografie. Ústav matematické statistiky. 12: i – 155. JSTOR 4355563.

- ^ Berman, Simeon M. (1992). „Recenze: Adler 1990 'Úvod do kontinuity ...'". Matematické recenze. PAN 1088478.

- ^ A b Dudley, R. M. (1967). "Velikosti kompaktních podmnožin Hilberta a kontinuita Gaussových procesů". Journal of Functional Analysis. 1 (3): 290–330. doi:10.1016/0022-1236(67)90017-1.

- ^ A b Marcus, M.B .; Shepp, Lawrence A. (1972). „Ukázkové chování Gaussových procesů“. Proceedings of the sixth Berkeley symposium on matematic statistics and probability, vol. II: teorie pravděpodobnosti. Univ. Kalifornie, Berkeley. str. 423–441.

- ^ A b Marcus, Michael B .; Shepp, Lawrence A. (1970). "Kontinuita Gaussových procesů". Transakce Americké matematické společnosti. 151 (2): 377–391. doi:10.1090 / s0002-9947-1970-0264749-1. JSTOR 1995502.

- ^ Driscoll, Michael F. (1973). "Reprodukční jádro Hilbertovy vesmírné struktury vzorových cest Gaussova procesu". Zeitschrift für Wahrscheinlichkeitstheorie und Verwandte Gebiete. 26 (4): 309–316. doi:10.1007 / BF00534894. ISSN 0044-3719. S2CID 123348980.

- ^ Jidling, Carl; Wahlström, Niklas; Wills, Adrian; Schön, Thomas B. (2017-09-19). "Lineárně omezené Gaussovy procesy". arXiv:1703.00787 [stat.ML ].

- ^ Dokumentace pro scikit-učit se také má podobné příklady.

- ^ Liu, W .; Principe, J.C .; Haykin, S. (2010). Adaptivní filtrování jádra: komplexní úvod. John Wiley. ISBN 978-0-470-44753-6. Archivovány od originál dne 04.03.2016. Citováno 2010-03-26.

- ^ Álvarez, Mauricio A .; Rosasco, Lorenzo; Lawrence, Neil D. (2012). "Jádra pro funkce s vektorovou hodnotou: recenze" (PDF). Základy a trendy ve strojovém učení. 4 (3): 195–266. doi:10.1561/2200000036. S2CID 456491.

- ^ Stein, M.L. (1999). Interpolace prostorových dat: Nějaká teorie pro Kriging. Springer.

- ^ Platanios, Emmanouil A .; Chatzis, Sotirios P. (2014). „Gaussova procesní směs podmíněná heteroscedasticita“. Transakce IEEE na analýze vzorů a strojové inteligenci. 36 (5): 888–900. doi:10.1109 / TPAMI.2013.183. PMID 26353224. S2CID 10424638.

- ^ Chatzis, Sotirios P. (2013). "Latentní variabilní Gaussův model procesu s procesem Pitman-Yor předchází klasifikaci více tříd". Neuropočítání. 120: 482–489. doi:10.1016 / j.neucom.2013.04.029.

- ^ Smola, A.J .; Schoellkopf, B. (2000). "Řídká aproximace chamtivé matice pro strojové učení". Sborník příspěvků ze sedmnácté mezinárodní konference o strojovém učení: 911–918. CiteSeerX 10.1.1.43.3153.

- ^ Csato, L .; Opper, M. (2002). "Řídké on-line gaussovské procesy". Neurální výpočet. 14 (3): 641–668. CiteSeerX 10.1.1.335.9713. doi:10.1162/089976602317250933. PMID 11860686. S2CID 11375333.

externí odkazy

- Web Gaussian Processes, včetně textu Rasmussena a Williamse Gaussian Processes for Machine Learning

- Jemný úvod do Gaussových procesů

- Přehled náhodných polí Gaussian a korelačních funkcí

- Efektivní učení výztuže pomocí Gaussových procesů

Software

- GPML: Komplexní sada nástrojů Matlabu pro regresi a klasifikaci GP

- STK: Malý (Matlab / Octave) Toolbox pro Kriging a GP modelování

- Modul Kriging v rámci UQLab (Matlab)

- Funkce Matlab / Octave pro stacionární Gaussova pole

- Yelp MOE - motor optimalizace černé skříňky využívající Gaussovo procesní učení

- ooDACE - Flexibilní objektově orientovaná sada nástrojů Kriging Matlab.

- GPstuff - sada nástrojů pro Gaussův proces pro Matlab a Octave

- GPy - Gaussovský procesní rámec v Pythonu

- GSTools - Geostatistical toolbox, including Gaussian process regression, written in Python

- Interaktivní ukázka regrese Gaussova procesu

- Základní gaussovská knihovna procesů napsaná v C ++ 11

- scikit-učit se - Knihovna strojového učení pro Python, která zahrnuje regresi a klasifikaci gaussovských procesů

- [1] - Nástroj Kriging toolKit (KriKit) je vyvíjen na Institutu bio- a geověd 1 (IBG-1) Forschungszentrum Jülich (FZJ)

![{ displaystyle operatorname {var} [X (t)] = operatorname {E} [| X (t) - operatorname {E} [X (t)] | ^ {2}] < infty quad { text {pro všechny}} t v T}](https://wikimedia.org/api/rest_v1/media/math/render/svg/ae643c93ad0f56457881fa60e3bdae082fd5e73a)

![{ displaystyle [0, varepsilon]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/09b79b1e11f2a6c9b36a919ddbbf91204fe7a1df)

![{ displaystyle lim _ {n to infty} operatorname {tr} [K_ {n} R_ {n} ^ {- 1}] < infty}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c62de62758eb883e4255dab480943abdebdb00d9)

![{ displaystyle Pr [f in { mathcal {H}} (R)] = 1}](https://wikimedia.org/api/rest_v1/media/math/render/svg/38ca6ca8c04250e643221318bc2b55241112519e)

![{ displaystyle lim _ {n to infty} operatorname {tr} [K_ {n} R_ {n} ^ {- 1}] = infty}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e133d11ae8a4dc2825314c86ec4c86df1aabb0fe)

![{ displaystyle Pr [f in { mathcal {H}} (R)] = 0}](https://wikimedia.org/api/rest_v1/media/math/render/svg/4cb02319fc30c845fd10102601b63961f296f931)

![{ displaystyle lim _ {n to infty} operatorname {tr} [R_ {n} R_ {n} ^ {- 1}] = lim _ {n to infty} operatorname {tr} [ I] = lim _ {n to infty} n = infty}](https://wikimedia.org/api/rest_v1/media/math/render/svg/70d34626fb759d05905dc20be06ded12144368c5)