Tf – idf - Tf–idf

v vyhledávání informací, tf – idf, TF * IDFnebo TFIDF, zkratka pro termín frekvence – inverzní frekvence dokumentu, je číselná statistika, která má odrážet, jak důležité je slovo pro dokument ve sbírce nebo korpus.[1] Často se používá jako váhový faktor při vyhledávání informací, dolování textu, a uživatelské modelování Hodnota tf – idf se zvyšuje proporcionálně kolikrát se slovo v dokumentu objeví, a je kompenzováno počtem dokumentů v korpusu, které slovo obsahují, což pomáhá přizpůsobit se tomu, že některá slova se obecně objevují častěji. tf – idf je dnes jedním z nejpopulárnějších systémů vážení termínů. Průzkum provedený v roce 2015 ukázal, že 83% textových doporučovacích systémů v digitálních knihovnách používá tf – idf.[2]

Variace váhového schématu tf – idf jsou často používány vyhledávače jako ústřední nástroj při hodnocení a hodnocení dokumentu relevantnost daný uživatel dotaz. tf – idf lze úspěšně použít pro stop-slova filtrování v různých oborech, včetně shrnutí textu a klasifikace.

Jeden z nejjednodušších hodnotící funkce se počítá sečtením tf – idf pro každý výraz dotazu; mnoho sofistikovanějších hodnotících funkcí jsou varianty tohoto jednoduchého modelu.

Motivace

Četnost termínů

Předpokládejme, že máme sadu anglických textových dokumentů a chceme je seřadit podle toho, který dokument je pro dotaz relevantnější, „hnědá kráva“. Jednoduchý způsob, jak začít, je vyloučit dokumenty, které neobsahují všechna tři slova „the“, „brown“ a „cow“, ale i tak zbývá mnoho dokumentů. Abychom je dále rozlišili, můžeme spočítat, kolikrát se v každém dokumentu vyskytuje každý výraz; kolikrát se v dokumentu vyskytne výraz, který se nazývá jeho četnost termínů. V případě, že se délka dokumentů velmi liší, jsou však často prováděny úpravy (viz definice níže). První forma vážení termínů je způsobena Hans Peter Luhn (1957), kterou lze shrnout jako:[3]

Váha termínu, který se v dokumentu vyskytuje, je jednoduše úměrná frekvenci termínu.

Četnost inverzních dokumentů

Protože termín „„ “je tak běžný, jeho frekvence bude mít tendenci nesprávně zdůrazňovat dokumenty, které používají slovo„ the “častěji, aniž by dostaly dostatečnou váhu smysluplnějším výrazům„ brown “a„ cow “. Termín „the“ není dobrým klíčovým slovem pro rozlišení relevantních a nerelevantních dokumentů a termínů, na rozdíl od méně obvyklých slov „brown“ a „cow“. Proto, an frekvence inverzních dokumentů je zahrnut faktor, který snižuje váhu výrazů, které se v sadě dokumentů vyskytují velmi často, a zvyšuje váhu výrazů, které se vyskytují zřídka.

Karen Spärck Jones (1972) koncipovali statistickou interpretaci termínové specificity nazvanou Inverse Document Frequency (idf), která se stala základním kamenem vážení termínů:[4]

Specifičnost termínu lze kvantifikovat jako inverzní funkci počtu dokumentů, ve kterých se vyskytuje.

Definice

- Tf – idf je produktem dvou statistik, četnost termínů a frekvence inverzních dokumentů. Existuje několik způsobů, jak určit přesné hodnoty obou statistik.

- Vzorec, jehož cílem je definovat důležitost klíčového slova nebo fráze v dokumentu nebo na webové stránce.

| váhové schéma | tf hmotnost |

|---|---|

| binární | |

| hrubý počet | |

| četnost termínů | |

| normalizace protokolu | |

| dvojitá normalizace 0,5 | |

| dvojitá normalizace K. |

Četnost termínů

V případě četnost termínů tf (t,d), nejjednodušší volbou je použít hrubý počet výrazu v dokumentu, tj. kolikrát byl tento výraz t vyskytuje se v dokumentu d. Pokud označíme hrubý počet Ft,d, pak je nejjednodušší tf schéma tf (t,d) = Ft,d. Mezi další možnosti patří[5]:128

- Booleovský "frekvence": tf (t,d) = 1 -li t se vyskytuje v d a 0 jinak;

- periodicita upravená podle délky dokumentu: tf (t,d) = Ft,d ÷ (počet slov v d)

- logaritmicky zmenšen frekvence: tf (t,d) = log (1 +.) Ft,d);[6]

- rozšířená frekvence, aby se předešlo zkreslení vůči delším dokumentům, např. hrubá frekvence dělená surovou frekvencí nejběžnějšího výrazu v dokumentu:

Četnost inverzních dokumentů

| váhové schéma | hmotnost IDF () |

|---|---|

| unární | 1 |

| frekvence inverzních dokumentů | |

| frekvence inverzních dokumentů plynulá | |

| frekvence inverzního dokumentu max | |

| pravděpodobnostní inverzní frekvence dokumentu |

The frekvence inverzních dokumentů je měřítkem toho, kolik informací slovo poskytuje, tj. jestli je běžné nebo vzácné ve všech dokumentech. To je logaritmicky zmenšen inverzní zlomek dokumentů, které obsahují slovo (získáno vydělením celkového počtu dokumentů počtem dokumentů, které obsahují výraz, a poté provedením logaritmu tohoto kvocientu):

s

- : celkový počet dokumentů v korpusu

- : počet dokumentů, kde je termín se objeví (tj. ). Pokud termín není v korpusu, povede to k rozdělení na nulu. Je proto běžné upravit jmenovatele na .

Četnost termínů - Četnost inverzních dokumentů

Pak se tf – idf počítá jako

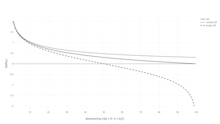

Vysoké hmotnosti v tf – idf je dosaženo ve vysoké době frekvence (v daném dokumentu) a nízká četnost dokumentů v celé sbírce dokumentů; váhy proto mají tendenci filtrovat běžné pojmy. Protože poměr uvnitř log funkce idf je vždy větší nebo roven 1, hodnota idf (a tf – idf) je větší nebo rovna 0. Jak se výraz vyskytuje ve více dokumentech, poměr uvnitř logaritmu se blíží 1 , čímž se idf a tf – idf přiblíží k 0.

| váhové schéma | váha výrazu dokumentu | váha termínu dotazu |

|---|---|---|

| 1 | ||

| 2 | ||

| 3 |

Odůvodnění idf

IDF zavedl jako „specifičnost výrazu“ Karen Spärck Jones v článku z roku 1972. Ačkoli to fungovalo dobře jako heuristický, jeho teoretické základy byly problematické nejméně tři desetiletí poté, přičemž se mnoho vědců pokoušelo najít teoretická informace zdůvodnění.[7]

Vlastní vysvětlení Spärcka Jonese nenavrhovalo mnoho teorie, kromě souvislosti s Zipfův zákon.[7] Byly provedeny pokusy dát idf na a pravděpodobnostní základ,[8] odhadem pravděpodobnosti, že daný dokument d obsahuje termín t jako relativní četnost dokumentů,

abychom mohli definovat idf jako

Frekvence inverzního dokumentu je logaritmus „inverzní“ relativní frekvence dokumentu.

Tato pravděpodobnostní interpretace má zase stejnou formu jako interpretace vlastní informace. Aplikování takovýchto informačních teoretických pojmů na problémy při získávání informací však vede k problémům při pokusu o definování vhodných prostory pro akce pro požadované rozdělení pravděpodobnosti: je třeba vzít v úvahu nejen dokumenty, ale také dotazy a podmínky.[7]

Souvislost s informační teorií

Frekvenci termínů a frekvenci inverzních dokumentů lze formulovat pomocí Informační teorie; pomáhá pochopit, proč mají jejich produkty význam z hlediska společného informačního obsahu dokumentu. Charakteristický předpoklad o rozdělení je to:

Tento předpoklad a jeho důsledky podle Aizawy: „představují heuristiku, kterou používá tf-idf.“[9]

Vzpomeňte si na výraz Podmíněná entropie „náhodně vybraného“ dokumentu v korpusu podmíněno skutečností, že obsahuje konkrétní výraz (a předpokládejme, že všechny dokumenty mají stejnou pravděpodobnost, že budou vybrány, a malé být r = pravděpodobnosti)):

Pokud jde o notaci, a jsou "náhodné proměnné" odpovídající příslušnému nakreslení dokumentu nebo výrazu. Nyní si připomeňte definici Vzájemné informace a všimněte si, že to může být vyjádřeno jako

Posledním krokem je rozšíření , bezpodmínečná pravděpodobnost nakreslení výrazu s ohledem na (náhodný) výběr dokumentu k získání:

Tento výraz ukazuje, že sečtením Tf-idf všech možných termínů a dokumentů se obnoví vzájemná informace mezi dokumenty a termínem se zohledněním všech specifik jejich společné distribuce[10]. Každý Tf-idf tedy nese „bit informací“ připojený k páru dokumentů x.

Příklad tf – idf

Předpokládejme, že máme tabulky počtu termínů korpusu skládající se pouze ze dvou dokumentů, které jsou uvedeny vpravo.

| Období | Počet termínů |

|---|---|

| tento | 1 |

| je | 1 |

| další | 2 |

| příklad | 3 |

| Období | Počet termínů |

|---|---|

| tento | 1 |

| je | 1 |

| A | 2 |

| vzorek | 1 |

Výpočet tf – idf pro termín „toto“ se provádí následovně:

Ve své surové formě frekvence je tf pouze frekvence „tohoto“ pro každý dokument. V každém dokumentu se slovo „toto“ objeví jednou; ale protože dokument 2 má více slov, jeho relativní frekvence je menší.

IDF je konstantní na každý korpus a účty pro poměr dokumentů, které obsahují slovo „this“. V tomto případě máme soubor dvou dokumentů a všechny obsahují slovo „toto“.

Tf – idf je tedy pro slovo „this“ nula, což znamená, že slovo není příliš informativní, protože se vyskytuje ve všech dokumentech.

Slovo „příklad“ je zajímavější - vyskytuje se třikrát, ale pouze ve druhém dokumentu:

Konečně,

(za použití základní 10 logaritmus ).

Nad rámec podmínek

Myšlenka tf – idf platí také pro jiné entity než termíny. V roce 1998 byl koncept citace aplikován na citace.[11] Autoři tvrdili, že „pokud dva dokumenty sdílejí velmi neobvyklou citaci, mělo by to mít větší váhu než citace uváděná velkým počtem dokumentů“. Kromě toho byl tf – idf použit na „vizuální slova“ za účelem provedení shody objektů ve videích,[12] a celé věty.[13] Koncept tf – idf se však ve všech případech neukázal jako efektivnější než prosté schéma tf (bez idf). Když byl na citace použit tf – idf, vědci nenašli žádné zlepšení oproti jednoduché váze počtu citací, která neměla žádnou součást idf.[14]

Deriváty

Z tf – idf pochází řada schémat vážení termínů. Jedním z nich je TF – PDF (Term Frequency * Proportional Document Frequency).[15] TF – PDF byl představen v roce 2001 v kontextu identifikace nově vznikajících témat v médiích. Složka PDF měří rozdíl v tom, jak často se výraz vyskytuje v různých doménách. Další derivát je TF – IDuF. V TF – IDuF,[16] idf se nepočítá na základě korpusu dokumentu, který má být prohledán nebo doporučen. Místo toho se idf počítá na osobních sbírkách dokumentů uživatelů. Autoři uvádějí, že TF – IDuF byl stejně účinný jako tf – idf, ale mohl by být použit také v situacích, kdy např. Uživatelský modelovací systém nemá přístup ke globálnímu korpusu dokumentu.

Viz také

Reference

- ^ Rajaraman, A .; Ullman, J.D. (2011). „Data Mining“ (PDF). Těžba masivních datových sad. s. 1–17. doi:10.1017 / CBO9781139058452.002. ISBN 978-1-139-05845-2.

- ^ Breitinger, Corinna; Gipp, Bela; Langer, Stefan (2015-07-26). „Systémy doporučujících výzkumných prací: průzkum literatury“. International Journal on Digital Libraries. 17 (4): 305–338. doi:10.1007 / s00799-015-0156-0. ISSN 1432-5012. S2CID 207035184.

- ^ Luhn, Hans Peter (1957). „Statistický přístup k mechanickému kódování a vyhledávání literárních informací“ (PDF). IBM Journal of Research and Development. 1 (4): 309–317. doi:10.1147 / kolo 14.0309. Citováno 2. března 2015.

Existuje také pravděpodobnost, že čím častěji se pojem a kombinace pojmů vyskytují, tím větší význam jim autor přikládá, protože odrážejí podstatu jeho celkové myšlenky.

- ^ Spärck Jones, K. (1972). "Statistická interpretace termínové specificity a její aplikace při vyhledávání". Deník dokumentace. 28: 11–21. CiteSeerX 10.1.1.115.8343. doi:10.1108 / eb026526.

- ^ Manning, C.D .; Raghavan, P .; Schutze, H. (2008). „Bodování, vážení termínů a model vektorového prostoru“ (PDF). Úvod do získávání informací. str. 100. doi:10.1017 / CBO9780511809071.007. ISBN 978-0-511-80907-1.

- ^ "Statistiky TFIDF | SAX-VSM".

- ^ A b C Robertson, S. (2004). "Porozumění četnosti inverzních dokumentů: O teoretických argumentech pro IDF". Deník dokumentace. 60 (5): 503–520. doi:10.1108/00220410410560582.

- ^ Viz také Odhady pravděpodobnosti v praxi v Úvod do získávání informací.

- ^ Aizawa, Akiko (2003). „Informační teoretická perspektiva opatření tf – idf“. Zpracování a správa informací. 39 (1): 45–65. doi:10.1016 / S0306-4573 (02) 00021-3.

- ^ Aizawa, Akiko (2003). „Informační teoretická perspektiva opatření tf – idf“. Zpracování a správa informací. 39 (1): 45–65. doi:10.1016 / S0306-4573 (02) 00021-3.

- ^ Bollacker, Kurt D .; Lawrence, Steve; Giles, C. Lee (01.01.1998). CiteSeer: Autonomní webový agent pro automatické načítání a identifikaci zajímavých publikací. Sborník z druhé mezinárodní konference o autonomních agentech. AGENTI '98. str. 116–123. doi:10.1145/280765.280786. ISBN 978-0-89791-983-8. S2CID 3526393.

- ^ Sivic, Josef; Zisserman, Andrew (01.01.2003). Video Google: Přístup k načítání textu při porovnávání objektů ve videích. Sborník z deváté mezinárodní konference IEEE o počítačovém vidění - svazek 2. ICCV '03. 1470–. doi:10.1109 / ICCV.2003.1238663. ISBN 978-0-7695-1950-0. S2CID 14457153.

- ^ Seki, Yohei. „Extrakce věty pomocí tf / idf a vážení pozic z novinových článků“ (PDF). Národní institut informatiky.

- ^ Beel, Joeran; Breitinger, Corinna (2017). „Hodnocení CC-IDF schématu vážení citací - Jak efektivně lze použít„ inverzní dokumentovou frekvenci “(IDF) na reference?“ (PDF). Sborník 12. konference.

- ^ Khoo Khyou Bun; Bun, Khoo Khyou; Ishizuka, M. (2001). Systém sledování nových témat. Sborník Třetí mezinárodní seminář o pokročilých problémech elektronického obchodování a webových informačních systémů. WECWIS 2001. str. 2. CiteSeerX 10.1.1.16.7986. doi:10.1109 / wecwis.2001.933900. ISBN 978-0-7695-1224-2. S2CID 1049263.

- ^ Langer, Stefan; Gipp, Bela (2017). „TF-IDuF: Nové schéma vážení termínů pro modelování uživatelů založené na sbírkách osobních dokumentů uživatelů“ (PDF). IConference.

- Salton, G; McGill, M. J. (1986). Úvod do moderního vyhledávání informací. McGraw-Hill. ISBN 978-0-07-054484-0.

- Salton, G.; Fox, E. A .; Wu, H. (1983). Msgstr "Rozšířené načítání logických informací". Komunikace ACM. 26 (11): 1022–1036. doi:10.1145/182.358466. hdl:1813/6351. S2CID 207180535.

- Salton, G.; Buckley, C. (1988). "Přístupy k vážení termínů při automatickém načítání textu" (PDF). Zpracování a správa informací. 24 (5): 513–523. doi:10.1016/0306-4573(88)90021-0. hdl:1813/6721.

- Wu, H. C .; Luk, R.W.P .; Wong, K.F .; Kwok, K.L. (2008). „Interpretace termínových vah TF-IDF při rozhodování o relevanci“. Transakce ACM v informačních systémech. 26 (3): 1. doi:10.1145/1361684.1361686. hdl:10397/10130. S2CID 18303048.

Externí odkazy a doporučené čtení

- Gensim je knihovna Pythonu pro modelování vektorového prostoru a zahrnuje vážení tf – idf.

- Robustní hypertextové odkazy: Aplikace tf – idf pro stabilní adresovatelnost dokumentu.

- Anatomie vyhledávače

- tf – idf a související definice jak se používá v Lucene

- TfidfTransformátor v scikit-učit se

- Generátor textu do matice (TMG) Sada nástrojů MATLAB, kterou lze použít pro různé úkoly při těžbě textu (TM), konkrétně i) indexování, ii) načítání, iii) redukce rozměrů, iv) shlukování, v) klasifikace. Krok indexování nabízí uživateli možnost použít místní a globální metody vážení, včetně tf – idf.