Ceph (software) - Ceph (software)

tento článek příliš spoléhá na Reference na primární zdroje. (Březen 2018) (Zjistěte, jak a kdy odstranit tuto zprávu šablony) |

| |

| Původní autoři | Skladování v nádrži (Šalvěj Weil, Yehuda Sadeh Weinraub, Gregory Farnum, Josh Durgin, Samuel Just, Wido den Hollander) |

|---|---|

| Vývojáři | Kanonický, CERN, Cisco, Fujitsu, Intel, červená čepice, SanDisk, a SUSE[1] |

| Stabilní uvolnění | 15.2.5 „Chobotnice“[2] / 16. září 2020 |

| Úložiště | |

| Napsáno | C ++, Krajta[3] |

| Operační systém | Linux, FreeBSD[4] |

| Typ | Obchod s distribuovanými objekty |

| Licence | LGPLv2.1[5] |

| webová stránka | ceph |

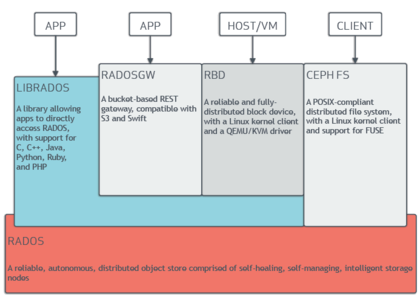

Ceph (výrazný /ˈsɛF/) je open-source software úložný prostor plošina, implementuje úložiště objektů na jednom distribuovaném počítačový cluster, a poskytuje rozhraní 3v1 pro: objekt-, blok- a na úrovni souboru úložný prostor. Ceph usiluje především o kompletně distribuovaný provoz bez a jediný bod selhání, škálovatelné na exabyte úrovni a volně k dispozici.

Ceph replikuje data a dělá je tolerantní k chybám,[6] použitím komoditní hardware a nevyžaduje žádnou konkrétní hardwarovou podporu. Díky své konstrukci je systém jak samoléčebný, tak i samospráva s cílem minimalizovat čas správy a další náklady.

Design

Ceph zaměstnává pět různých druhů démoni:[7]

- Klastrové monitory (ceph-mon), které sledují aktivní a neúspěšné uzly clusteru, konfiguraci clusteru a informace o umístění dat a stavu globálního clusteru.

- Zařízení pro ukládání objektů (ceph-osd), které používají přímé úložiště žurnálu na disku (pojmenované BlueStore,[8] který od vydání v12.x nahrazuje FileStore[9] který by používal souborový systém)

- Metadata servery (ceph-mds) do této mezipaměti a přístup brokera inody a adresáře uvnitř souborového systému CephFS.

- HTTP brány (ceph-rgw), které vystavují vrstvu úložiště objektů jako rozhraní kompatibilní s Amazon S3 nebo OpenStack Swift API

- Manažeři (ceph-mgr), kteří provádějí úkoly monitorování, účetnictví a údržby klastrů a rozhraní s externími monitorovacími systémy a správou (např. balancer, dashboard, Prometheus, Plugin Zabbix)[10]

Všechny jsou plně distribuovány a mohou běžet na stejné sadě serverů. Klienti s různými potřebami mohou přímo komunikovat s jejich různými podmnožinami.[11]

Ceph ano prokládání jednotlivých souborů napříč více uzly k dosažení vyšší propustnosti, podobně jako RAID0 odstraní oddíly napříč více pevné disky. Adaptivní vyvažování zátěže je podporováno, přičemž často přístupné objekty jsou replikovány přes více uzlů.[Citace je zapotřebí ] Od září 2017[Aktualizace], BlueStore je výchozí a doporučený typ úložiště pro produkční prostředí,[12] což je vlastní implementace úložiště Ceph poskytující lepší latenci a konfigurovatelnost než backend úložiště souborů a vyhnout se nedostatkům úložiště založeného na souborovém systému zahrnujícím další vrstvy zpracování a ukládání do mezipaměti. Backend Filestore je stále považován za užitečný a velmi stabilní; XFS býval doporučovaným základním typem souborového systému pro produkční prostředí, zatímco Btrfs bylo doporučeno pro neprodukční prostředí. ext4 souborové systémy nebyly doporučeny z důvodu výsledných omezení maximální délky objektů RADOS.[13] I při použití BlueStore se XFS používá pro malý oddíl metadat.[14]

Úložiště objektů

Ceph implementuje distribuované nástroje úložiště objektů - BlueStore. Softwarové knihovny společnosti Ceph poskytují klientským aplikacím přímý přístup k spolehlivé autonomní úložiště distribuovaných objektů (RADOS) objektový úložný systém a také poskytuje základ pro některé z funkcí Ceph, včetně Blokovací zařízení RADOS (RBD), Brána RADOSa Systém souborů Ceph.

"Librados" softwarové knihovny poskytnout přístup v C, C ++, Jáva, PHP, a Krajta. Brána RADOS také vystavuje úložiště objektů jako Klidný rozhraní, které se může prezentovat jako nativní Amazon S3 a OpenStack Swift API.

Blokovat úložiště

Systém ukládání objektů Ceph umožňuje uživatelům připojit Ceph jako tenké rezervy blokovat zařízení. Když aplikace zapisuje data do Ceph pomocí blokovacího zařízení, Ceph automaticky odstraní a replikuje data v klastru. Ceph Blokovací zařízení RADOS (RBD) také integruje s Virtuální stroje založené na jádře (KVM).

Ceph RBD rozhraní se stejným systémem úložiště objektů Ceph, který poskytuje rozhraní librados a souborový systém CephFS, a ukládá obrázky blokových zařízení jako objekty. Vzhledem k tomu, že RBD je postaveno na libradech, zdědí RBD libradosovy schopnosti, včetně snímků jen pro čtení a návratu k snímku. Prokládáním obrázků napříč klastrem zlepšuje Ceph výkon přístupu ke čtení pro velké blokové obrázky zařízení.

Blokové zařízení lze virtualizovat a poskytovat úložiště bloků virtuálním strojům na virtualizačních platformách, jako je Apache CloudStack, OpenStack, OpenNebula, Ganeti, a Virtuální prostředí Proxmox.

Souborový systém

Souborový systém Ceph (CephFS) běží na stejném systému úložiště objektů, který poskytuje úložiště objektů a blokuje rozhraní zařízení. Klastr serverů metadat Ceph poskytuje službu, která mapuje adresáře a názvy souborů systému souborů na objekty uložené v klastrech RADOS. Klastr serveru metadat se může rozšiřovat nebo smršťovat a může dynamicky vyvažovat systém souborů a distribuovat data rovnoměrně mezi hostitele klastru. To zajišťuje vysoký výkon a zabraňuje těžkým nákladům na konkrétních hostitelích v klastru.

Klienti připojí POSIX -kompatibilní souborový systém používající a Linuxové jádro klient. Starší POJISTKA K dispozici je také klient na bázi. Servery běží jako běžný Unix démoni.

Dějiny

Ceph byl původně vytvořen Šalvěj Weil pro něj disertační práce,[15] což doporučil profesor Scott A. Brandt v Jacku Baskin School of Engineering, University of California, Santa Cruz (UCSC) a sponzoruje Pokročilý simulační a výpočetní program (ASC), včetně Národní laboratoř Los Alamos (LANL), Sandia National Laboratories (SNL) a Lawrence Livermore National Laboratory (LLNL).[16] První řádek kódu, který skončil jako součást Cephu, napsal Sage Weil v roce 2004, zatímco na letní stáži v LLNL pracoval na škálovatelné správě metadat souborového systému (dnes známý jako Cephův MDS).[17] V roce 2005 vytvořil Sage Weil v rámci letního projektu iniciovaného Scottem A. Brandtem a vedeným Carlosem Maltzahnem plně funkční prototyp souborového systému, který přijal jméno Ceph. Ceph debutoval tím, že Sage Weil přednesl dvě prezentace v listopadu 2006, jednu v USENIX OSDI 2006[18] a další v SC '06.[19]

Po ukončení studia na podzim 2007 Weil pokračoval v práci na Ceph na plný úvazek a hlavní vývojový tým se rozšířil o Yehuda Sadeh Weinraub a Gregory Farnum. 19. března 2010 Linus Torvalds sloučil klienta Ceph do linuxového jádra verze 2.6.34[20][21] který byl vydán 16. května 2010. V roce 2012 vytvořil Weil Skladování v nádrži za profesionální služby a podporu pro Ceph.[22][23]

V dubnu 2014 červená čepice koupil Inktank, což přineslo většinu vývoje Ceph interně.[24]

V říjnu 2015 byl zřízen poradní výbor komunity Ceph, aby komunitě pomáhal řídit směr softwarově definované úložné technologie s otevřeným zdrojovým kódem. Charterová poradní rada zahrnuje členy komunity Ceph z globálních IT organizací, které se angažují v projektu Ceph, včetně jednotlivců z Kanonický, CERN, Cisco, Fujitsu, Intel, červená čepice, SanDisk, a SUSE.[25]

Historie vydání

| název | Uvolnění | První vydání | Konec život | Milníky |

|---|---|---|---|---|

| Argonaut | 0.48 | 3. července 2012 | První hlavní „stabilní“ vydání | |

| Bobtail | 0.56 | 1. ledna 2013 | ||

| Sépie obecná | 0.61 | 7. května 2013 | ceph-deploy je stabilní | |

| Knedlík | 0.67 | 14. srpna 2013 | Květen 2015 | jmenný prostor, region, monitorování REST API |

| Císař | 0.72 | 9. listopadu 2013 | Květen 2014 | replikace multi-datového centra pro radosgw |

| Světluška | 0.80 | 7. května 2014 | Dubna 2016 | kódování vymazání, odstupňování mezipaměti, primární afinita, backend OSD klíč / hodnota (experimentální), samostatný radosgw (experimentální) |

| Obří | 0.87 | 29. října 2014 | Dubna 2015 | |

| Kladivo | 0.94 | 7. dubna 2015 | Srpna 2017 | |

| Infernalis | 9.2.0 | 6. listopadu 2015 | Dubna 2016 | |

| Klenot | 10.2.0 | 21. dubna 2016 | 2018-06-01 | Stabilní CephFS, experimentální back-end RADOS s názvem BlueStore |

| Kraken | 11.2.0 | 20. ledna 2017 | 2017-08-01 | BlueStore je stabilní |

| Svítící | 12.2.0 | 29. srpna 2017 | ||

| Napodobit | 13.2.0 | 1. června 2018 | snímky jsou stabilní, Beast je stabilní | |

| Nautilus | 14.2.0 | 19. března 2019 | ||

| Chobotnice | 15.2.0 | 23. března 2020 | ||

| Pacifik | 16.0.0 |

Etymologie

Název „Ceph“ je zkratkou „hlavonožce ", třída měkkýši který zahrnuje chobotnici. Název (zdůrazněný logem) naznačuje vysoce paralelní chování chobotnice a byl vybrán, aby spojil souborový systém s „Sammy“, banánový slimák maskot UCSC.[7] Oba hlavonožci a banánové slimáci jsou měkkýši.

Viz také

- BeeGFS

- Distribuovaný systém souborů

- Distribuované paralelní souborové systémy odolné proti chybám

- Souborový systém Gfarm

- GlusterFS

- IBM General Parallel File System (GPFS)

- Ještěrka

- Lesk

- MapR FS

- Moose File System

- OrangeFS

- Paralelní virtuální souborový systém

- Systém souborů Quantcast

- RozoFS

- XtreemFS

- ZFS

- Porovnání distribuovaných souborových systémů

Reference

- ^ „Poradní výbor komunitních formulářů Ceph“. 2015-10-28. Archivovány od originál dne 2019-01-29. Citováno 2016-01-20.

- ^ „v15.2.5 Octopus propuštěn“.

- ^ „GitHub Repository“.

- ^ „Čtvrtletní zpráva o stavu FreeBSD“.

- ^ „Licenční soubor LGPL2.1 ve zdrojích Ceph“. 2014-10-24. Citováno 2014-10-24.

- ^ Jeremy Andrews (15.11.2007). „Ceph Distributed Network File System“. KernelTrap. Archivovány od originál dne 17.11.2007. Citováno 2007-11-15.

- ^ A b C M. Tim Jones (04.06.2010). „Ceph: Linuxový distribuovaný souborový systém v petabajtovém měřítku“ (PDF). IBM. Citováno 2014-12-03.

- ^ „BlueStore“. Ceph. Citováno 2017-09-29.

- ^ „Migrace BlueStore“. Citováno 2020-04-12.

- ^ „Démon manažera Ceph - dokumentace Ceph“. docs.ceph.com. Citováno 2019-01-31.

- ^ Jake Edge (14.11.2007). „Souborový systém Ceph“. LWN.net.

- ^ Sage Weil (2017-08-29). „v12.2.0 Luminous Released“. Blog Ceph.

- ^ „Doporučení pro pevný disk a souborový systém“. ceph.com. Archivovány od originál dne 2017-07-14. Citováno 2017-06-26.

- ^ „Reference ke konfiguraci BlueStore“. Citováno 12. dubna 2020.

- ^ Sage Weil (01.12.2007). „Ceph: Spolehlivé, škálovatelné a vysoce výkonné distribuované úložiště“ (PDF). University of California, Santa Cruz.

- ^ Gary Grider (01.05.2004). „ASCI / DOD Scalable I / O History and Strategy“ (PDF). University of Minnesota. Citováno 2019-07-17.

- ^ Dynamic Metadata Management for Petabyte-Scale File Systems, SA Weil, KT Pollack, SA Brandt, EL Miller, Proc. SC'04, Pittsburgh, PA, listopad, 2004

- ^ „Ceph: Škálovatelný a vysoce výkonný distribuovaný systém souborů,“ SA Weil, SA Brandt, EL Miller, DDE Long, C Maltzahn, Proc. OSDI, Seattle, WA, listopad 2006

- ^ „CRUSH: Controlled, scalable, decentralized placement of replicated data,“ SA Weil, SA Brandt, EL Miller, DDE Long, C Maltzahn, SC'06, Tampa, FL, listopad 2006

- ^ Sage Weil (2010-02-19). „Klient sloučen s 2.6.34“. ceph.newdream.net.

- ^ Tim Stephens (2010-05-20). „Nová verze operačního systému Linux zahrnuje souborový systém Ceph vyvinutý na UCSC“. news.ucsc.edu.

- ^ Bryan Bogensberger (03.05.2012). „A vše se spojuje“. Blog Inktank. Archivovány od originál dne 19. 7. 2012. Citováno 2012-07-10.

- ^ Joseph F. Kovar (10. července 2012). „10 nejúžasnějších spuštění úložiště v roce 2012 (zatím)“. CRN. Citováno 19. července 2013.

- ^ Red Hat Inc (2014-04-30). „Red Hat získá společnost Inktank, poskytovatel Ceph“. červená čepice. Citováno 2014-08-19.

- ^ „Poradní výbor pro komunitní formuláře Ceph“. 2015-10-28. Archivovány od originál dne 2019-01-29. Citováno 2016-01-20.

Další čtení

- M. Tim Jones (04.05.2010). „Ceph: Linuxový distribuovaný souborový systém v petabajtovém měřítku“. developerWorks> Linux> Technická knihovna. Citováno 2010-05-06.

- Jeffrey B. Layton (2010-04-20). „Ceph: Tvor distribuovaného systému souborů z laguny objektů“. Linux Magazine. Citováno 2010-04-24.

- Carlos Maltzahn; Esteban Molina-Estolano; Amandeep Khurana; Alex J. Nelson; Scott A. Brandt; Sage Weil (srpen 2010). „Ceph jako škálovatelná alternativa k distribuovanému systému souborů Hadoop“. ;přihlásit se:. 35 (4). Citováno 2012-03-09.

- Martin Loschwitz (24. dubna 2012). „Úložiště objektů RADOS a souborový systém Ceph“. HPC ADMIN Magazine. Citováno 2012-04-25.